Continuando a nossa série de artigos sobre inteligência artificial generativa (IAG), hoje abordaremos as formas de identificar e avaliar os riscos corporativos relacionados à essa tecnologia. Se você ainda não leu nossos conteúdos anteriores, recomendamos que acesse o IA Hub, onde encontrará outros artigos de nossa série, como: O que é Inteligência Artificial? / O que é IA Responsável? / Governança de Inteligência Artificial. Além disso, não deixe de acompanhar nossas redes sociais e se inscrever em nossa newsletter especializada em IA!

A identificação e avaliação de riscos corporativos em IA são essenciais para garantir uma implementação ética, segura e legal da tecnologia nas organizações. É fundamental que as empresas adotem estratégias claras e alinhadas aos seus valores na gestão desses riscos, assegurando uma abordagem proativa e eficaz para mitigar potenciais desafios ao utilizar a IA.

A incorporação da IA nas operações corporativas pode trazer benefícios significativos, mas também introduz desafios e riscos se implementada sem os devidos processos de governança. Identificar e avaliar continuamente esses riscos são aspectos fundamentais para implementar com sucesso soluções de IA nas empresas. Os riscos de IA podem ser de diferentes tipos. Por exemplo, dependendo de como a tecnologia for incorporada na empresa, é possível que ela afete negativamente a qualidade e confiabilidade dos serviços, o que pode impactar a credibilidade da organização e a satisfação dos usuários, além de trazer riscos legais.

/ Como identificar os riscos?

A identificação envolve a análise minuciosa de todas as fases do ciclo de vida de um sistema de IA, desde o seu desenvolvimento até a implementação e manutenção contínua[1]. Em termos gerais, para identificar esses riscos, é essencial considerar os princípios éticos definidos pela empresa para o uso de IA e realizar uma análise abrangente dos riscos ligados à implementação desses sistemas. Isso inclui a identificação dos possíveis impactos adversos que a IA pode causar em operações, produtos, serviços e partes interessadas.

Para identificação de tais riscos, o WEF[2] sugere a investigação de quatro áreas-chave: estruturas e medidas de governança internas; determinação do nível de envolvimento humano na tomada de decisões com auxílio de IA; gestão das operações; e interação e comunicação com as partes interessadas.

/ Como avaliar os riscos?

Após a identificação, a avaliação dos riscos entra em cena. Este segundo passo implica em uma análise mais profunda e quantitativa dos riscos identificados na etapa anterior. A avaliação busca entender a probabilidade de ocorrência e o impacto potencial de cada risco, priorizando a mitigação dos mais críticos. A avaliação dos riscos de IA pode incluir:

- Análise de impacto: avaliar as consequências potenciais de cada risco, considerando fatores como perda financeira, danos à reputação e impacto operacional.

- Probabilidade de ocorrência: avaliar a probabilidade de cada risco se concretizar, levando em consideração fatores como a complexidade do sistema, a exposição a ameaças externas e a maturidade da tecnologia.

- Classificação de riscos: classificar os riscos identificados com base em sua gravidade e urgência, permitindo a alocação eficiente de recursos para a mitigação.

- Desenvolvimento de estratégias de mitigação: criar estratégias específicas para mitigar cada risco, implementando controles, procedimentos e protocolos de segurança adequados.

- Monitoramento contínuo: estabelecer um sistema de monitoramento contínuo para avaliar a eficácia das estratégias de mitigação ao longo do tempo e realizar ajustes conforme necessário.

/ Na prática

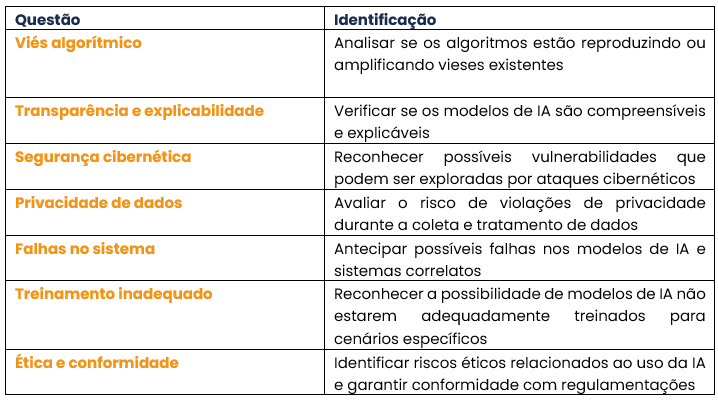

Produzimos a tabela abaixo para exemplificação da identificação e avaliação de alguns dos principais riscos da IA para a governança corporativa[3]:

________________________________

[1] Principais referências: Market Guide for AI Trust, Risk and Security Management (gartner.com) e Market Guide for AI Trust, Risk and Security Management (gartner.com)

[3] fonte principal para identificação de riscos: NIST.AI.100-1.pdf (p. 28 e ss)